11.4 Appendici

11.4.1 Filtro di Hilbert

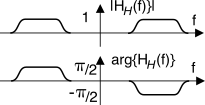

Il

filtro di Hilbert è caratterizzato da una risposta in frequenza descritta analiticamente come

ed il cui andamento di modulo e fase può essere rappresentato come nella figura a

a lato. Ricordando infatti che

± j = e± j π 2 e che

sgn(f) = ⎧⎨⎩ 1 f > 0 −1 f < 0 , otteniamo un andamento

costante del modulo

|HH(f)| = 1, ed un gradino discendente per la fase, ossia

∠HH(f) = ⎧⎪⎨⎪⎩ − π2 f > 0 π 2 f < 0

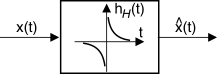

Il passaggio di un segnale

x(t) attraverso il filtro di Hilbert produce un secondo segnale

^x(t) detto

trasformata di Hilbert del primo, indicata come

^x(t) = H{x(t)}, ed il cui andamento in frequenza ha espressione

^X(f) = F {^x(t)} = HH(f) X(f) = − j ⋅ sgn(f) ⋅ X(f)

ossia differisce da

X(f) per uno sfasamento di

∓ π 2 per frequenze rispettivamente positive o negative. Per la trasformata di Hilbert sussistono le proprietà riportate in nota.

Realizzazione del filtro di Hilbert

Sintetizzare un filtro che consegua esattamente la risposta in frequenza descritta dalla (

14.25) è un compito pressoché impossibile, a causa della brusca transizione della fase in corrispondenza di

f = 0.

In realtà, il filtro di Hilbert si usa principalmente per segnali modulati, che non presentano componenti spettrali a frequenze prossime allo zero. Pertanto, lo stesso scopo può essere svolto da un diverso filtro HH(f), con andamento più dolce della fase, e che presenti gli stessi valori nominali del filtro di Hilbert solamente per le frequenze comprese nella banda di segnale.

Risposta impulsiva del filtro di Hilbert

Vogliamo dimostrare ora che l’antitrasformata della

(14.25) risulta pari a

in modo da poter esprimere la trasformata di Hilbert nella forma di un integrale di convoluzione

^x(t) = H{x(t)} = 1 π ∫∞−∞ x(τ)t − τ dτ = x(t) * 1πt

Riutilizzando infatti un risultato trovato al §

3.8.6 siamo già arrivati a mostrare che

e dato che

HH(f) = − j ⋅ sgn(f), sembra che ci dovrebbe essere un modo semplice di arrivare a

sistemare le cose. La

(14.27), una volta eliminato il termine

1⁄2, permette di scrivere

F {sgn(t)} = − j πf e dunque

Applicando ora alla

(14.28) la proprietà di dualità (vedi pag.

1, dove si asserisce che se

G(f) = F {g(t)}, allora

F {G(t)} = g(−f)) otteniamo

F ⎧⎩− 1πt⎫⎭ = − j ⋅ sgn(−f) = j ⋅ sgn(f), e dunque arriviamo al risultato anticipato

F −1{HH(f)} = F −1{ − j ⋅ sgn(f)} = 1πt

11.4.2 Trasformata di Hilbert di un segnale modulato

Si intende dimostrare che se

xc(t) ed

xs(t) sono limitate in banda

± W con

W < f0, allora risulta

e dunque dalla

(14.1) si ottiene

x̂(t) = H{xc(t)cos2πf0t − xs(t)sin2πf0t} = xc(t)sinω0t + xs(t)cosω0t

e quindi

x̂(t) = ℑ{x(t)e jω0t} come espresso dall’eq.

(14.10). Limitiamoci a dimostrare la prima delle

(14.29), ovvero che

Iniziamo con il considerare che

F -trasformando l’argomento di

(14.30) possiamo evidenziarne le componenti a frequenza positiva e negativa

Xc(f − f0) e

Xc(f + f0)

che, se

xc(t) ha una banda minore di

f0, possono essere facilmente

H-trasformate semplicemente aggiungendo lo sfasamento introdotto a frequenze positive e negative dal filtro di Hilbert

1 2 [Xc(f − f0) + Xc(f + f0)] H ⇒ 12 [Xc(f − f0)e −jπ2 + Xc(f + f0)e jπ2]

e quindi

F -antitrasformando questa espressione si ottiene la

H-trasformata del segnale

(14.30)

1 2 [Xc(f − f0)e −jπ2 + Xc(f + f0)e jπ2] F − 1 ⇒ xc(t) 2(e j2πf0te −jπ 2 + e −j2πf0te jπ 2)

risultato che, anche se non ancora nella forma anticipata, poteva comunque essere ottenuto anche direttamente a partire dal secondo membro di

(14.31), invocando subito la limitazione ad una semibanda di

xc(t)e±j2πf0t. Per ottenere la

(14.30) è ora sufficiente moltiplicare e dividere per

j = e jπ2, ossia

xc(t)2(e j2πf0te −jπ 2 + e −j2πf0te jπ 2) ⋅ e jπ 2 e jπ 2 = xc(t) 2j(e j2πf0t + e −j2πf0te jπ) = = xc(t)2j(e j2πf0t − e −j2πf0t) = xc(t)sin2πf0t

in quanto

e jπ2 = j, e

e jπ = − 1.

11.4.3 Trasmissione a banda laterale unica

Con riferimento alla figura che segue, consideriamo un segnale

a(t) reale e limitato in banda, con

A(f) = A*(−f) (grafico

[a]). In virtù delle proprietà di simmetria coniugata per segnali reali la conoscenza del solo contenuto a frequenze positive

f > 0, ovvero di

A+(f) = A(f) rectW⎛⎝f − W 2⎞⎠, è sufficiente a definire

a(t) in modo completo. Se consideriamo ora il segnale modulato

x(t) = a(t)cosω0t, anch’esso reale, otteniamo che

X(f) [b], oltre ad essere a simmetria coniugata rispetto all’origine, ha simmetria coniugata anche rispetto ad

f0:

X+(f0 + α) = {X+(f0 − α)}*.

Questo risultato mostra come sia teoricamente possibile (con una fotocopiatrice ed un paio di forbici!) produrre un segnale Y(f) eliminando da X(f) tutta la banda |f| < f0 [d], e quindi da quel che resta, ri-ottenere il segnale X(f) a partire da un Y(f). La ricostruzione di X(f) avviene infatti (frecce tratteggiate) spostando le copie duplicate di Y+(f) e Y−(f) come indicato dalle frecce.

Una volta verificata la correttezza ipotetica di questo procedimento che ci consente di ricevere per intero X(f) trasmettendone solo metà (cioè Y(f)), osserviamo che anche Y(f) è a simmetria coniugata rispetto a zero (ossia Y(f) = Y*(−f)), e quindi la sua antitrasformata y(t) è reale, e dunque può essere realmente trasmesso.

A parte il “dettaglio” di come ricostruire “veramente”

X(f) a partire da

Y(f), ci chiediamo: esiste una formula per ottenere

y(t) in modo

diretto a partire da

a(t)? La risposta è positiva, e si trova al §

12.1.2.

11.4.4 Processo passa banda

Svolgiamo ora l’approfondimento dei passaggi che portano ai risultati discussi al §

11.3, ovvero l’espressione della densità di potenza

Pxc(f) e

Pxs(f) in funzione di

Px(f) eq.

(14.24), svolgendo i calcoli in modo da tenere in conto anche il caso dei processi aleatori: pertanto, occorrerà prima ottenere un risultato relativo alle rispettive funzioni di autocorrelazione

Rxc(τ) e

Rxs(τ), e quindi effettuare la trasformata di Fourier come prescritto dal teorema di Wiener.

Osserviamo innanzitutto che quando un processo aleatorio presenta una

Px(f) limitata in banda attorno ad

f0, la relativa funzione di autocorrelazione

Rx(τ) = F −1{ Px(f)} può essere espressa nei termini delle componenti analogiche di bassa frequenza della funzione di autocorrelazione stessa:

Rx(τ) = Rc(τ) cosω0τ − Rs(τ) sinω0τ

D’altra parte, una qualunque realizzazione di un processo

x(t) limitato in banda attorno ad

f0 ammette la rappresentazione

x(t) = xc(t)cosω0t − xs(t)sinω0t, ma data la natura aleatoria di

x(t), gli stessi

xc(t) ed

xs(t) sono realizzazioni di processi, in generale statisticamente

dipendenti, in quanto la loro combinazione deve produrre un

x(t) che appartiene al processo originario. Si pensi ad esempio al segnale

x(t) = xc(t)cosω0t, in cui

xc(t) è un processo stazionario ed ergodico: come già osservato al §

7.5.3,

x(t) è solamente

ciclostazionario.

Come prima cosa, proviamo a calcolare la funzione di autocorrelazione dell’inviluppo complesso di una generica realizzazione, che per l’ergodicità corrisponde al relativo momento misto:

Queste quattro quantità sono calcolate al §

11.4.5, e nel caso in cui

xc(t) e

xs(t) siano stazionari ed ergodici, il risultato finale fornisce le espressioni

in cui

^Rx(τ) = H{Rx(τ)} è la trasformata di Hilbert di

Rx(τ). Osserviamo quindi come, sostituendo

(14.33) in

(14.32), risulti

e pertanto otteniamo

in cui

Pxc(f) = Pxs(f) sono reali pari in quanto

xc(t) ed

xs(t) sono reali. Prima di giungere alle conclusioni espresse al §

11.4.4.1 ed anticipate al §

11.3, prendiamoci

il lusso di sviluppare una serie di considerazioni basate sui risultati fin qui ottenuti:

- la (14.35) sembra indicare che Px(f) possa assumere valori complessi, perdendo il senso fisico di potenza, ma non è così. Osserviamo infatti che Rxcxs(τ) è un segnale reale dispari: pertanto Pxcxs(f) = F {Rxcxs(τ)} è completamente immaginario, e dunque Px(f) è reale;

- se risulta Rxcxs(τ) = 0 per ogni τ, allora la potenza mutua Pxcxs(f) si annulla, e la (14.35) fornisce Px(f) = 2 Pxc(f) reale pari; la presenza di Pxcxs(f) ≠ 0 può invece rendere Px(f) asimmetrico, permettendo di ottenere ancora Px(f) = 4 P+x(f + f0) come espresso dalla (14.22);

- invertendo i due punti precedenti osserviamo che, se Px(f) ha simmetria pari rispetto ad f0, allora Px(f) è pari, e quindi deve risultare Rxcxs(τ) = 0, ovvero le c.a. di b.f. xc(t) ed xs(t) risultano mutuamente incorrelate; se inoltre queste sono congiuntamente gaussiane, allora risultano anche statisticamente indipendenti;

- se xc(t) e xs(t) sono a media nulla, la potenza Pxc (uguale a Pxs in virtù della prima delle (14.33)) si calcola come Rxc(0) = Rxs(0). Dato che Rxcxs(τ) = − Rxsxc(τ) è dispari (punto 1), deve risultare che Rxcxs(0) = 0; in questo caso la (14.34) fornisce Rx(0) = 2Rxc(0) = 2Rxs(0), e dunque si ottiene

Px = σ2x = Rx(0) = 2Rxc(0) = 2Rxs(0) = 2σ2xc = 2σ2xs = 2 Pxc = 2 Pxs

In definitiva, le componenti analogiche di bassa frequenza hanno entrambe potenza pari a metà di quella dell’inviluppo complesso;

- l’eq. (14.22) asserisce che Px(f) = 4 Px+(f + f0), ed in modo simile si può trovare che Px(f) = 4 Px−(f − f0), e quindi Px+ = Px− = 14 Px. Dato poi che Px = Px+ + Px− in quanto x+(t) e x−(t) sono ortogonali perché definiti su bande disgiunte, in base al punto 4 si ottiene

Px = Px+ + Px− = 14[ Px + Px] = 1 2 Px = Pxc = Pxs

e dunque xc(t) e xs(t) hanno (ciascuno) potenza pari a quella di x(t), ovvero Pxc = Pxs = Px;

- se consideriamo ^x(t) l’uscita del filtro di Hilbert per il quale risulta |HH(f)|2 = 1, si ottiene che Px̂(f) = |HH(f)|2 Px(f) = Px(f), e dunque antitrasformando R^x(τ) = Rx(τ);

- è possibile mostrare che, esprimendo l’autocorrelazione di x(t) in termini delle sue c.a. di b.f. Rx(τ) = Rc(τ)cosω0τ − Rs(τ)sinω0τ, risulta

⎧⎨⎩ Rc(τ) = Rxc(τ) Rs(τ) = − Rxcxs(τ)

- la prima delle (14.33) ci dice che Pxc(f) = Pxs(f) in quanto Rxc(τ) = Rxs(τ), e che risulta

Rxc(τ) = Rxs(τ) = Rx(τ)cosω0τ + ^Rx(τ)sinω0τ

applicando ora la formula di Eulero per seno e coseno si ottiene

Rxc(τ) = Rxs(τ) = = Rx(τ) e jω0τ + e −jω0τ 2 + ^Rx(τ) e jω0τ − e −jω0τ 2j = 1 2 [Rx(τ) − j^Rx(τ)] e jω0τ + 1 2 [Rx(τ) + j^Rx(τ)] e −jω0τ = R − x(τ) e jω0τ + R + x(τ) e −jω0τ

infatti i termini tra parentesi quadre corrispondono alla definizione di componenti a frequenze positive e negative ottenute tramite trasformata di Hilbert, per come espressa dalla (14.17).

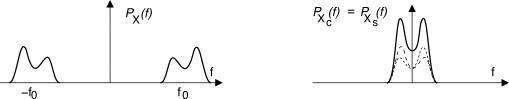

Al punto 8) del precedente elenco abbiamo mostrato che

Rxc(τ) = Rxs(τ) = R−x(τ) e jω0τ + R+x(τ) e −jω0τ

e quindi

Pxc(f) = Pxs(f) = P −x(f − f0) + P+x(f + f0)

dunque lo spettro di densità di potenza delle componenti analogiche di un processo si ottiene traslando nell’origine e sovrapponendo (vedi fig.

11.31) le componenti a frequenze positive e negative dello spettro di densità di potenza

Px(f) del segnale modulato. Dunque

Pxc(f) e

Pxs(f) sono entrambe pari, come deve essere per

xc(t) ed

xs(t) reali.

11.4.4.2 Processo gaussiano bianco limitato in banda

Se

x(t) è un processo gaussiano stazionario ergodico, bianco ed a media nulla, con densità spettrale

Px(f) = N0 2 limitata in banda

± W attorno ad

f0, allora (vedi fig.

11.32)

- le relative c.a. di b.f. xc(t) e xs(t) sono processi congiuntamente gaussiani, stazionari, ergodici, statisticamente indipendenti ed a media nulla, con potenza Pxc = Pxs = Px = 2N0W, pari alle varianze σ2x = σ2xc = σ2xs. Le rispettive densità di potenza valgono

- il suo inviluppo complesso x(t) relativo ad f0 ha potenza (e densità di potenza) doppie

Infatti la simmetria pari di

Px(f) attorno ad

f0 rende

xc(t) e

xs(t) incorrelate, come mostrato al punto 3) di pag.

1: pertanto

Pxcxs(f) = F {Rxcxs(τ)} = 0 (punto 2) e dunque la

(14.35) si semplifica nella

(14.37).

11.4.5 Autocorrelazione di processi passa-banda

Svolgiamo qui il calcolo relativo al valore di

Rxc(τ),

Rxs(τ),

Rxcxs(τ) e

Rxsxc(τ). Ricordando che (pag.

1)

xc(t) = x(t)cosω0t + ^x(t)sinω0t, iniziamo a svolgere i calcoli per

Rxc(τ):

Rxc(τ) = E{xc(τ)xc(t + τ)} = = E{[x(t)cosω0t + ^x(t)sinω0t] ⋅ ⋅ [x(t + τ)cosω0(t + τ) + ^x(t + τ)sinω0(t + τ)]} = = E{x(t)x(t + τ)} ⋅ cosω0t ⋅ cosω0(t + τ) + + E{x(t)^x(t + τ)} ⋅ cosω0t ⋅ sinω0(t + τ) + + E{^x(t)x(t + τ)} ⋅ sinω0t ⋅ cosω0(t + τ) + + E{^x(t)^x(t + τ)} ⋅ sinω0t ⋅ sinω0(t + τ)

Valutiamo quindi singolarmente i quattro valori attesi, procedendo con il calcolo di medie temporali in virtù dell’ergodicità, e indicando con

x(t) la media temporale di

x(t), ossia

x(t) = limT → ∞ 1T ∫T ⁄ 2 − T ⁄ 2x(t)dt:

E{x(t)x(t + τ)} = x(t)x(t + τ) = Rx(τ) E{x(t)^x(t + τ)} = x(t)^x(t + τ) = Rx^x(τ) = x(−τ) * ^x(τ) = = x(−τ) * x(τ) * 1 πτ = Rx(τ) * 1 πτ = ^Rx(τ) E{^x(t)x(t + τ)} = ^x(t)x(t + τ) = R^xx(τ) = ^x(−τ) * x(τ) = = x(−τ) * ⎛⎝− 1 πτ⎞⎠ * x(τ) = x(−τ) * x(τ) * ⎛⎝− 1 πτ⎞⎠ = = Rx(τ) * ⎛⎝− 1 πτ⎞⎠ = − ^Rx(τ) E{^x(t)^x(t + τ)} = ^x(t)^x(t + τ) = R^x^x(τ) = ^x(−τ) * ^x(τ) = = x(−τ) * ⎛⎝− 1 πτ⎞⎠ * x(τ) * 1 πτ = = x(−τ) * x(τ) * ⎛⎝− 1 πτ⎞⎠ * 1 πτ = − ^^Rx(τ) = Rx(τ)

Sostituendo le relazioni ora trovate nella espressione di Rxc(τ), si ottiene

Rxc(τ) = Rx(τ) ⋅ cosω0t ⋅cosω0(t + τ) + ^Rx(τ) ⋅ cosω0t ⋅sinω0(t + τ) + − ^Rx(τ) ⋅ sinω0t ⋅cosω0(t + τ) + Rx(τ) ⋅ sinω0t ⋅sinω0(t + τ) = = 1 2 Rx(τ)[cosω0(−τ) + cosω0(2t + τ)] + + 12 ^Rx(τ)[sinω0(τ) + sinω0(2t + τ)] + − 12 ^Rx(τ)[sinω0(−τ) + sinω0(2t + τ)] + + 12 Rx(τ)[cosω0(−τ) − cosω0(2t + τ)] = = Rx(τ) ⋅ cosω0τ + ^Rx(τ) ⋅ sinω0τ

che costituisce il risultato anticipato alla

(14.33). Per l’espansione dei termini trigonometrici, si è fatto uso delle relazioni

cosα ⋅ cosβ = 1 2 [cos(α − β) + cos(α + β)] sinα ⋅ sinβ = 1 2 [cos(α − β) − cos(α + β)] sinα ⋅ cosβ = 1 2 [sin(α − β) + sin(α + β)]

I calcoli relativi al valore di

Rxs(τ) sono del tutto simili, ed il loro svolgimento porta al risultato

Rxc(τ) = Rxs(τ).

Per quanto riguarda Rxcxs(τ) applichiamo la relazione xs(t) = ^x(t)cosω0t − x(t)sinω0t per ottenere

Rxcxs(τ) = E{xc(τ)xs(t + τ)} = = E{[x(t)cosω0t + ^x(t)sinω0t] ⋅ ⋅ [^x(t + τ)cosω0(t + τ) − x(t + τ)sinω0(t + τ)] = = E{x(t)^x(t + τ)} ⋅ cosω0t ⋅ cosω0(t + τ) + − E{x(t)x(t + τ)} ⋅ cosω0t ⋅ sinω0(t + τ) + + E{^x(t)^x(t + τ)} ⋅ sinω0t ⋅ cosω0(t + τ) + − E{^x(t)x(t + τ)} ⋅ sinω0t ⋅ sinω0(t + τ)

I valori attesi che vediamo comparire sono già stati ricavati e quindi possiamo scrivere direttamente lo sviluppo dei calcoli, in cui si applicano nuovamente le identità trigonometriche note:

Rxcxs(τ) = ^Rx(τ) ⋅ cosω0t ⋅ cosω0(t + τ) − Rx(τ) ⋅ cosω0t ⋅ sinω0(t + τ) + + Rx(τ) ⋅ sinω0t ⋅ cosω0(t + τ) + ^Rx(τ) ⋅ sinω0t ⋅ sinω0(t + τ) = = 1 2 ^Rx(τ)[cosω0(−τ) + cosω0(2t + τ)] + − 12 Rx(τ)[sinω0(τ) + sinω0(2t + τ)] + + 12 Rx(τ)[sinω0(−τ) + sinω0(2t + τ)] + + 12 ^Rx(τ)[cosω0(−τ) − cosω0(2t + τ)] = = − Rx(τ) ⋅ sinω0τ + ^Rx(τ) ⋅ cosω0τ

ottenendo così il risultato preannunciato alla

(14.33).

I calcoli relativi al valore di Rxsxc(τ) sono del tutto simili, ed il loro svolgimento porta al risultato Rxsxc(τ) = − Rxcxs(τ).