7.5 Operazioni elementari sui segnali

Al §

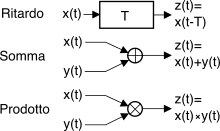

5.2 abbiamo visto come gli elementi filtranti possano essere realizzati mediante una combinazione delle tre operazioni elementari mostrate in figura, ovvero

ritardo,

somma e

prodotto.

Prima di proseguire, approfondiamo dunque il risultato della combinazione di segnali certi ed aleatori mediante gli operatori introdotti. Iniziamo osservando che per i due casi di somma e prodotto si possono verificare le seguenti combinazioni:

- x(t) segnale certo e y(t) processo aleatorio: il risultato è (in generale) un processo non stazionario, infatti ora le medie d’insieme dipendono, istante per istante, dal valore che il segnale certo assume in quell’istante;

- x(t) segnale periodico e y(t) processo aleatorio: si ottiene un processo detto ciclostazionario, in quanto anche se le statistiche variano nel tempo, esse assumono valori identici con periodicità uguale a quella del segnale certo;

- x(t) segnale costante pari ad a e y(t) processo aleatorio: z(t) è un processo della stessa natura di y(t), con media mz pari alla somma (od il prodotto) tra my ed a, potenza Pz = Py + a2 (oppure ⋅ a2), e autocorrelazione Rz(τ) = Ry(τ) ⋅ a2 (oppure +a2).

Notiamo inoltre che spesso si può trattare un segnale periodico alla stregua di un processo, semplicemente ipotizzando per lo stesso una fase uniforme nell’arco di un periodo, in modo da ricondursi al caso del processo armonico, vedi §

7.2.3. Dunque, nel seguito trattiamo solo il caso dei processi.

Questo costituisce un caso particolare di canale perfetto (pag.

1), ed analiticamente corrisponde alla convoluzione con un impulso traslato

z(t) = x(t) * δ(t − T). Pertanto, l’unica cosa che si modifica in uscita è lo spettro di fase, in cui compare un termine lineare, ovvero

Z(f) = X(f) ⋅ e −j2πfT, mentre valor medio, autocorrelazione e densità di potenza/energia restano invariate, così come non cambiano la varianza e la d.d.p. per il caso di processi.

7.5.2 Somma tra segnali aleatori

Procediamo nel calcolo delle grandezze rappresentative avvalendoci (a parte per il valor medio) della ipotesi di indipendenza statistica tra x(t) e y(t):

mz = E{x(t) + y(t)} = E{x(t)} + E{y(t)} = mx + my

Notiamo che questo risultato è valido anche in assenza di indipendenza statistica .

Pz = E{(x(t) + y(t))2} = E{x2(t)} + E{y2(t)} + 2E{x(t) ⋅ y(t)} = = Px + Py + 2mxmy

dato che per processi statisticamente indipendenti la d.d.p. congiunta

pXY(x, y) si fattorizza nel prodotto delle marginali

pX(x)pY(y), così come si fattorizza il valore atteso del prodotto ; anche i prossimi risultati valgono unicamente sotto l’ipotesi di

indipendenza statistica.

Dalle due relazioni precedenti otteniamo

σ2z = E{(z(t) − mz)2} = Pz − (mz)2 = Px + Py + 2mxmy − (mx + my)2 = = Px − (mx)2 + Py − (my)2 = σ2x + σ2y

Rz(τ) = E{z(t)z(t + τ)} = E{(x(t) + y(t))(x(t + τ) + y(t + τ))} = = E{x(t)x(t + τ)} + E{y(t)y(t + τ)} + E{x(t)y(t + τ)} + E{x(t + τ)y(t)} = = Rx(τ) + Ry(τ) + 2mxmy

dato che per processi indipendenti, stazionari e congiuntamente ergodici risulta

E{x(t)y(t + τ)} = Rxy(τ) pari cioè al prodotto delle medie

mxmy, vedi eq.

(10.151). Osserviamo anche come per

τ = 0 si ritrovi il valore della potenza totale

Pz.

Spettro di densità di potenza

Pz(f ) = F {Rz(τ)} = Px(f) + Py(f) + 2mxmyδ(f)

e rimarchiamo ancora una volta che in caso di processi

non indipendenti il risultato

non è valido.

Nel caso di

x(t) ed

y(t) indipendenti si ottiene che il processo somma è caratterizzato da una densità

di ampiezza pari a

Tale risultato conferma quello già ottenuto al §

6.2.5 e relativo alla somma di variabili aleatorie, ovvero che la d.d.p. di una somma di v.a. indipendenti si ottiene per

convoluzione tra le densità dei termini della somma.

Notiamo infine che se vengono sommati due processi gaussiani il risultato è ancora gaussiano, come discusso al §

6.5.2: infatti la convoluzione tra funzioni gaussiane è ancora una gaussiana, con media pari alla somma delle medie, e varianza alla somma delle varianze.

7.5.3 Prodotto tra segnali aleatori

Anche per il prodotto tra segnali valgono le considerazioni svolte al §

7.5. Qualora i fattori

x(t) ed

y(t) del prodotto

z(t) siano processi statisticamente indipendenti, stazionari e congiuntamente ergodici, si ha

mz = E{z(t)} = E{x(t)y(t)} = E{x(t)} E{y(t)} = mx ⋅ my

dato che come già osservato risulta

pXY(x, y) = pX(x)pY(y) permettendo così la fattorizzazione del valore atteso del prodotto, ossia

∬ x y p(x, y)dxdy = ∫ x p(x)dx ⋅ ∫ y p(y)dy

Pz = E{z2(t)} = E{x2(t)y2(t)} = E{x2(t)} E{y2(t)} = Px ⋅ Py

σ2z = E{(z(t) − mz)2} = Pz − (mz)2 = Px ⋅ Py − (mx ⋅ my)2

Funzione di autocorrelazione

Rz(τ) = E{z(t)z(t + τ)} = E{x(t)y(t)x(t + τ)y(t + τ)} = = E{x(t)x(t + τ)} E{y(t)y(t + τ)} = Rx(τ) ⋅ Ry(τ)

In particolare, notiamo che l’incorrelazione di uno dei due processi, per un certo valore di

τ, provoca l’incorrelazione del prodotto, allo stesso istante

τ.

Spettro di densità di potenza

Pz(f) = F {Rz(τ)} = F {Rx(τ) ⋅ Ry(τ)} = Px(f) * Py(f)

ossia è pari alla convoluzione tra le densità spettrali dei fattori. Notiamo quindi che la densità di potenza del prodotto presenta una occupazione di banda maggiore di quella dei singoli fattori.

Si calcola con le regole per il cambiamento di variabile, illustrate al §

6.4. Nel caso in cui i due processi

x e

y siano statisticamente indipendenti, il risultato è

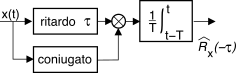

7.5.4 Stima della autocorrelazione

Come primo esempio dell’uso degli operatori elementari, la figura che segue mostra l’architettura di uno schema di elaborazione idoneo a effettuare una stima

^Rx(τ) della funzione di autocorrelazione (§

7.1.4) di un segnale

x(t) per un

anticipo τ assegnato: infatti calcola

^Rx(−τ) = 1T ∫Tt − Tx*(t)x(t − τ)dt per

τ ≥ 0, da cui

^Rx(τ) si ottiene applicando l’eq.

(10.159). Il blocco integratore è un filtro passa-basso con una

h(t) = 1T rectT(t).

Variando

τ si ottiene

^Rx(τ) per i diversi valori dell’argomento, e se

x(t) è stazionario possiamo calcolare

^Px(f) = F {^Rx(τ)}; se infine

x(t) è un membro di un processo ergodico,

^Px(f) rappresenta una stima della densità di potenza per una qualunque realizzazione.