7.2 Spettro di densità di potenza

Siamo finalmente in grado di caratterizzare questa densità spettrale sia per il caso dei processi che per gli altri tipi di segnale, di potenza, periodico, o di energia. Lo strumento che lo consente è il...

7.2.1 Teorema di Wiener

Si enuncia senza troppe complicazioni:

Lo spettro di densità di potenza Px(f) (o di energia Ex(f)) di un segnale x(t) certo o aleatorio è pari alla trasformata di Fourier della relativa funzione di autocorrelazione, ovvero Px(f) = F {Rx(τ)}

La dimostrazione del teorema per segnali di energia è straordinariamente semplice:

Rx(τ) = ⌠⌡∞−∞ x*(t)x(t + τ)dt = ⌠⌡∞−∞ X*(f)X(f) e j2πfτdf = = F −1{X*(f)X(f)} = F −1{Ex(f)}

in cui abbiamo prima applicato il teorema di Parseval (pag.

1), poi la proprietà di traslazione nel tempo, e quindi (vedi §

3.2) riconosciuta

X*(f)X(f) come la densità di energia

Ex(f).

Come anticipato, il teorema è valido anche per segnali di potenza, per i quali la funzione di autocorrelazione

Rx(τ) da cui partire è quella espressa dalla

(10.154) ( ). Nel caso di processi ergodici, ogni membro del processo possiede la stessa

Px(f), che dunque può essere calcolata a partire dalla

Rx(τ) di uno qualunque di essi. Nel caso di processi stazionari almeno in senso lato, infine, l’autocorrelazione da cui partire è il momento misto

m(1, 1)XX(τ) = E{x(t)x(t + τ)} calcolato come media di insieme dalla

(10.153), e rappresenta il modo più generale di procedere, come applicato al §

7.7.4 per il caso di un segnale dati.

Il teorema di Wiener è (nella sua semplicità) uno strumento molto potente che può costituire una

strada alternativa per verificare ed estendere risultati noti. Ad esempio, la proprietà di massimo nell’origine per l’autocorrelazione

Rx(0) = Px può ora essere ricavata da quella del valore iniziale eq.

(10.38):

Rx(0) = F −1{Px(f)}|τ = 0 = ∞⌠⌡ −∞ Px(f)e j2πfτdf|τ = 0 = ∞⌠⌡ −∞ Px(f)df = Px

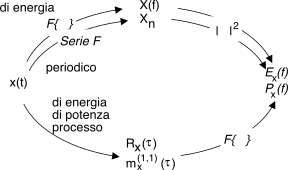

D’altra parte, la validità del teorema anche per segnali periodici e di energia consente di intraprendere per essi

due percorsi alternativi per il calcolo delle corrispondenti

Px(f) e

Ex(f), come illustrato nella figura a lato.

Dato che in virtù del teorema di Wiener è ora possibile definire una Px(f) anche per processi e segnali di potenza, molto spesso nel testo ci si riferirà alle densità di potenza o di energia anziché alle trasformate dei segnali, in modo da applicare i risultati a tutti i casi possibili.

Applichiamo ora ad alcuni casi notevoli di segnale certo e processo aleatorio la relazione tra Px(f) e Rx(τ) espressa dal teorema di Wiener.

7.2.2 Segnale periodico

In questo caso

x(t) con periodo

T può essere espresso mediante la relativa serie di Fourier

(10.7) x(t) = ∑∞n = −∞Xn e j2πnFt riferita alla frequenza fondamentale

F = 1⁄T (o prima armonica), e sviluppando in tal senso la

(10.158) si ottiene che l’autocorrelazione di

x(t) ha espressione

Rx(τ) = ∑∞n = −∞|Xn|2 e j2πnFτ, ovvero può essere espressa in serie di Fourier, e quindi è a sua volta periodica, come già osservato. La relativa densità di potenza

Px(f) risulta dunque pari a

che costituisce una conferma del teorema di Parseval

(10.13). A pag.

1 sono riportati alcuni esempi di autocorrelazione e densità di potenza per segnali periodici.

Come osservato a pag.

1, se il segnale può essere scritto come

x(t) = x0(t) + a in cui

E{x0(t)} = 0 ed

a è una costante, si ottiene

Rx(τ) = Rx0(τ) + a2 e dunque

Px(f) = F {Rx(τ)} = Px0(f) + a2δ(f), ossia la relativa densità spettrale presenta un impulso nell’origine di area

a2. Ovvero, dal punto di vista

opposto, un impulso nell’origine di

Px(f) indica la presenza di una componente continua in

x(t).

7.2.3 Processo armonico

Si tratta del segnale sinusoidale introdotto a pag.

1 e la cui fase iniziale è aleatoria, espresso come

in cui il parametro

θ è una v.a. con d.d.p. uniforme tra

− π e

π, ovvero

pΘ(θ) = 12π rect2π(θ). In tal caso

x(t, θ) costituisce un processo ergodico (vedi §

6.3.7), la cui d.d.p.

pX(x) = 1π√ A2 − x2

è graficata a pagina

1.

Dato che

a ciascuna realizzazione del processo armonico (ad esempio quella con

θ = 0) corrisponde la medesima densità di potenza

Px(f) = A2 4 [δ(f − f0) + δ(f + f0)], possiamo ottenere l’autocorrelazione

Rx(t) (10.161) senza dover svolgere l’integrale

(10.158), e neanche la media di insieme

(10.153). Infatti, per il teorema di Wiener si ha

Rx(t) = F −1{ Px(f)} = A2 4 [e j2πf0t + e −j2πf0t] = A22 cos(2πf0t)

Questo risultato conferma che l’autocorrelazione di un segnale periodico è periodica; riflettiamo dunque sulla circostanza che anche un seno, od un coseno con qualunque altra fase, avrebbe avuto la stessa

Rx(t). Ciò è d’altra parte evidente, avendo tutti questi segnali uguale densità di potenza

Px(f).

7.2.4 Processo gaussiano bianco limitato in banda

Un processo

n(t) è chiamato

bianco quando la densità di potenza è

costante in frequenza, ovvero quando si esprime come

Pn(f) = N0 2 rect2W(f)

in cui

W è l’occupazione di banda a frequenze positive. Per questo caso l’autocorrelazione vale

e possiamo pertanto constatare che si ottiene

Rn(0) = Pn = ⌠⌡∞−∞Pn(f)df = ⌠⌡W − WN0 2 df = N0W = σ2n

in cui l’ultima eguaglianza sussiste (vedi eq.

(10.119) a pag.

1) in quanto l’assenza di impulsi nell’origine per

Pn(f) corrisponde ad un

n(t) a media nulla. Inoltre, dato che

Rn(t) si azzera per

t = k⁄2W, osserviamo che campionando

n(t) con periodo

Tc = 1⁄2W si ottengono valori

incorrelati, e se il processo è gaussiano, anche statisticamente indipendenti (vedi §

6.5.1). Questo risultato giustifica, almeno da un punto di vista teorico, una ipotesi che viene spesso fatta: quella di trovare, sovrapposti ai campioni di un segnale limitato in banda, dei campioni di rumore

statisticamente indipendenti.

All’aumentare di W, Rn(t) tende a zero più rapidamente, cosicché il rumore si mantiene correlato per un tempo sempre minore, ovvero due campioni separati da uno stesso intervallo temporale t hanno una correlazione sempre minore. Un risultato simile vale anche più in generale, in quanto l’autocorrelazione Rx(t) di un qualsiasi processo a media nulla (tranne nel caso periodico, riconducibile ad una combinazione di processi armonici) tende a 0 con t → ∞, ovvero da un certo t in poi la correlazione è trascurabile.

Infine, se immaginiamo il rumore bianco limitato in banda come il risultato del transito di un processo gaussiano a banda infinita (quindi, con

Rn(t) = δ(t)) attraverso un filtro passa basso ideale con

H(f) = rect2W(f) (vedi §

15.4.1), ci accorgiamo che la correlazione

(10.162) tra campioni di rumore in uscita presi ad istanti diversi

(t ≠ 0) è una diretta conseguenza della memoria introdotta dalla risposta impulsiva

h(t) = 2W sinc(2Wt) sul segnale in transito, dato che l’operazione di convoluzione tra

n(t) e

h(t) rende i valori in uscita una

combinazione lineare di quelli (passati) in ingresso (vedi §

3.4.3).

Esercizio Sia dato un processo gaussiano ergodico a media nulla e con densità di potenza Px(f) = Px2β β2 + 4(πf)2 in cui β = 0.2 e Px = 5.

- Esprimere la relativa funzione di autocorrelazione Rx(τ);

- esprimere la d.d.p. pX(x) di una v.a. x estratta dal processo ad un istante casuale;

- esprimere vettore medio mx e matrice di covarianza Σx di una coppia di v.a. x1 e x2 estratte con un intervallo τ, ovvero x1 = x(t) e x2 = x(t + τ), per un valore di τ = 10.

Svolgimento In base alla tabella al §

3.8.8 risulta che

F −1⎧⎩ 2β β2 + 4(πf)2 ⎫⎭ = e− β|t|, dunque

-

Rx(τ) = F −1{Px(f)} = Px e− β|τ| = 5 ⋅ e− 0.2|τ|

- abbiamo evidentemente a che fare con una v.a. gaussiana, dunque pX(x) = 1√ 2π σx e− (x − mx)2 2σ2x in cui σ2x = Px = 5 in quanto a media nulla, e pari al massimo di Rx(τ) per τ = 0;

- la coppia x1x2 è un vettore aleatorio gaussiano bidimensionale, il cui valor medio è nullo in base alla stazionarietà ed all’essere il processo a media nulla, mentre Σx è una matrice 2 × 2 sulla cui diagonale compare Rx(0) = σ2x mentre nelle altre due posizioni compare la covarianza

σx1x2 = m(1, 1)x1x2(τ = 10) = Rx(τ = 10) = 5 ⋅ e− 0.2 ⋅ 10 = 0.68

dunque mx = ⎡⎢⎣ 0 0 ⎤⎥⎦ e Σx = ⎡⎢⎣ 5 0.68 0.68 5 ⎤⎥⎦.

7.2.5 Processo di segnale dati

Al §

15.1.2 descriveremo un generico segnale numerico come una somma di repliche di una funzione

g(t), ognuna moltiplicata per un diverso valore

an rappresentativo delle informazioni da trasmettere:

La presenza della variabile aleatoria

θ a distribuzione uniforme tra

± T2 (per cui

pΘ(θ) = 1T rectT(θ)), rende

x(t) un processo ergodico (vedi pag.

1).

Si mostrerà in appendice (§

7.7.4) che, nelle ipotesi in cui le ampiezze

an siano determinazioni di variabili aleatorie

indipendenti ed

identicamente distribuite, a

media nulla e varianza

σ2A( ), la densità spettrale di potenza del processo

(10.163) risulta

mentre nel caso in cui gli

an siano

statisticamente dipendenti, e/o a media

non nulla, il risultato è più complesso (vedi eq.

(10.192)). Limitandoci ad

interpretare il risultato

semplice espresso dalla

(10.164), notiamo che

Eg(f) è la densità di energia di una singola replica di

g(t), la cui ripetizione, con periodo

T, fornisce una densità di potenza

media Eg(f)T. Se ogni replica di

g(t) è moltiplicata per una v.a. indipendente a media nulla e varianza (potenza)

σ2A, la densità di potenza

Px(f) aumenta di egual misura (vedi §

7.5.3).